Noelle Martin, a Nyugat-ausztrál Egyetem aktivistája és kutatója 11 évvel ezelőtt fedezte fel, hogy arcát pornográf jellegű tartalmakban használták fel. Eleinte „csak” képek készültek róla, de az elmúlt néhány évben már videók is, amiket többnyire pornóoldalakon osztottak meg a felhasználók. A képek hiába nem különösebben valósághűek, így is helyrehozhatatlan kárt tudnak okozni az embernek – mondja.

„Ez mindenre hatással van a foglalkoztathatóságodtól a jövőbeli keresőképességen át a kapcsolataidig. Ez a visszaélés egyik formája, aminek örökké tartó következményei vannak” – fogalmaz Martin, akinek az állásinterjúkon és a randevúkon is beszélnie kell arról, hogy a beleegyezése nélkül készített pornográf tartalmak áldozata lett.

Tavaly pedig egy New Jersey-i középiskolás diáklány, Francesca Mani indított kampányt azért, hogy törvénnyel szabályozzák az AI által generált pornográf felvételeket, miután kiderült, hogy iskolatársai szexuális tartalmú felvételeket készítettek róla és 30 másik osztálytársnőjéről mesterséges intelligencia segítségével, a beleegyezésük nélkül.

Francescának azzal kellett szembesülnie, hogy az Egyesült Államokban nem kapnak jogi segítséget az ilyen jellegű felvételek áldozatai, és nem ő az egyetlen olyan gyerek, akit a saját kortársai hoztak megalázó helyzetbe a róla készült meghamisított felvételekkel. Gyakran éppen az alanyok iskola-, illetve osztálytársai az elkövetők, akik ezután szétküldik az iskolában a képeket és videókat, és ezzel gyakorlatilag szexuálisan zaklatják az áldozataikat.

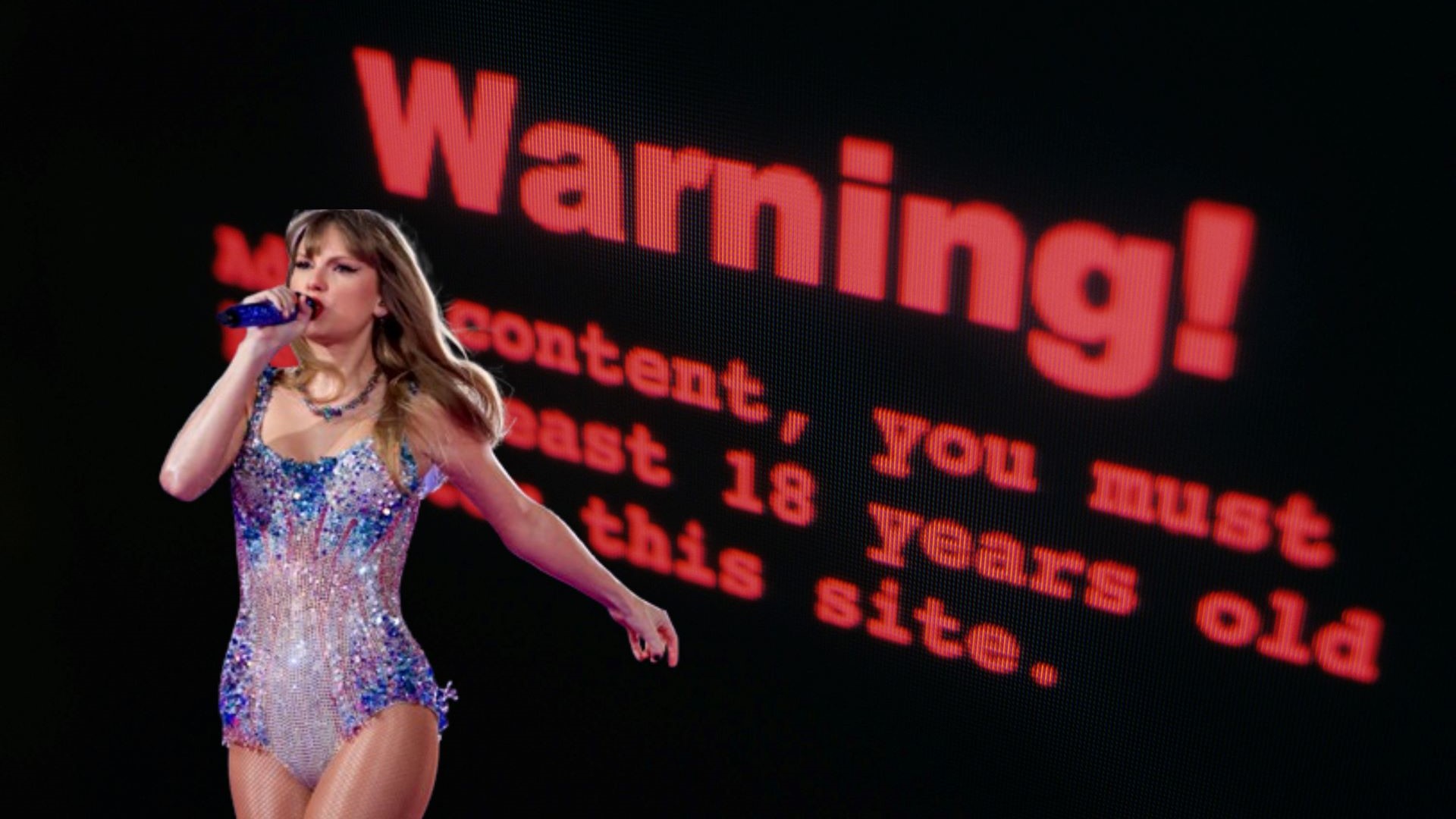

Az AI-pornó jelensége egyáltalán nem új keletű: 2011-ben Scarlett Johanssonról jelentek meg olyan deepfake felvételek, amiket nemhogy nem ő készített, de valójában nem is szerepel rajtuk. Christen Bell 2020-ban, idén januárban pedig Taylor Swift esett áldozatul a mesterséges intelligencia által generált videók készítőinek.

Az énekesnő arcát ábrázoló felvételeket egy AI-celebpornó oldalon fedezték fel január 15-én, és nem kellett sok idő, hogy elterjedjenek a legnagyobb közösségi média portálok, például a Twitter, a Facebook vagy a Reddit felhasználói között. Az egyik képet a posztoló fiók felfüggesztése előtt 47 millió alkalommal nézték meg. A megtekintések száma sokkal kevesebb is lehetett volna, mégis több mint 17 órába telt, mire a platform eltávolította a bejegyzést.

A női áldozatok vannak többségben

Miközben folyamatos párbeszéd zajlik arról, hogy a mesterséges intelligencia által generált felvételeket hogyan lehet felhasználni az elnökválasztások befolyásolására és a dezinformáció terjesztésére, szinte alig hallunk arról, hogy a nők számára miért jelent problémát egy ilyen jellegű felvétel.

Azok az emberek, akik az alany beleegyezése nélkül készült pornográf képeket néznek, akár valódiak, akár mesterséges intelligencia által készültek, a szexuális erőszak egy formáját követik el – mondta Kristen Zaleski, a Dél-kaliforniai Egyetem mentális egészségügyi osztályának igazgatója.

A deepfake felvételek ugyanis az áldozatok egész további életére hatással lehetnek, gyakran elítélik őket a munkahelyükön és a közösségeikben. Zaleski például már dolgozott együtt egy kisvárosi tanárral, aki elvesztette az állását, miután a szülők tudomást szereztek a róla (de nem általa) készített pornográf AI-tartalmakról.

A mesterséges intelligenciával foglalkozó DeepTrace Labs 2019-es jelentése szerint a hamisított pornográf felvételek alanyai túlnyomó többségben (96%-ban) nők. De hiába nem valódiak a szóban forgó képek és videók, ha valakit a beleegyezése nélkül ábrázolnak szexuális kontextusban, azzal súlyosan megsértik a jogait és a magánéletét, mert az ilyen jellegű tartalmak elmossák a határvonalakat a valóság és a fikció között, nem mellesleg megalázzák és lealacsonyítják az áldozataikat.

Igazából sehol nem lehetünk biztonságban

Ben Decker, a Memetica digitális nyomozási tanácsadó ügynökség vezetője szerint a közösségimédia-cégek nem rendelkeznek valóban hatékony eszközökkel az ilyen jellegű tartalmak megfigyeléséhez.

A legtöbb nagyobb közösségimédia-platformhoz hasonlóan ugyan a Twitter irányelvei is tiltják a manipulált tartalmak megosztását, de a Metához hasonlóan ők is kizsigerelték a moderátor csapatuk nagy részét, és helyettük főként automatizált rendszerekre, illetve felhasználói jelentésekre támaszkodnak.

Sajnos nincs más lehetőség, saját magunkat kell megvédenünk a deepfake felvételek gyártóitól. Érdemes például privát fiókra váltanunk a közösségi médiában, és a fényképeinket lehetőleg csak azokkal osszuk meg, akikben valóban megbízunk – az AI-bosszúpornó készítői ugyanis sok esetben személyesen ismerik a célpontjukat.

Soha nem tudhatjuk ugyanis, hogy ki nézegeti még a profilunkat. Nem árt azzal is tisztában lennünk, hogy a felvételek elkészítéséhez használt eszközöknek több különböző szögből készült képre is szükségük van ahhoz, hogy valósághű hamisítványokat készítsenek, így a képeinken érdemes minél kevesebb oldalról mutatnunk az arcunkat.

Egyre növekvő tendencia

Az MI-programok terjedése és hozzáférhetősége miatt egyre nehezebb elejét venni a deepfake pornográfiának. Az elkövetők és terjesztők felelősségre vonása azért is jelent kihívást, mert amíg az országok egyenként szabályozhatják a mesterséges intelligencia által generált pornográf felvételeket, addig az internet valójában nemzetközi, és mindenhova elér a keze.

Legutóbb Taylor Swift esetében merült fel, hogy a mesterséges intelligencia által generált képsorok nem törvénybe ütközőek. James O’Connell ügyvéd ekkor a Mirror című brit napilapnak nyilatkozva kifejtette, hogy a jelenség annyira új, hogy a legtöbb országban nincsenek törvények a deepfake szabályozására, ugyanis az AI-nak nincs jogi státusza – nem egy perelhető vagy bebörtönözhető személy, csak szoftver. A szakértő szerint a valódi bűnös az az ember, aki a hamisított pornót létrehozó szoftvert futtatja, és akit gyakorlatilag lehetetlen visszakeresni.

Már önmagában az is sokkoló, hogy a Taylor Swiftet ábrázoló felvételeknek meg kellett jelenniük ahhoz, hogy elkezdjünk beszélni erről a már évek óta problémát jelentő jelenségről, miközben a bosszúpornóhoz hasonlóan az deepfake is egy olyan fegyver, amit már évek óta bevetnek a nők ellen, és amelynek áldozatai nem csak a Reddit-fórumokon terjedő, pornósztárok testére photoshopolt celebek, hanem lényegében bármelyikünk lehet.

De talán a Ticketmaster 2022-es összeomlásához (akkora kereslet volt Taylor Swift világ körüli turnéjára, hogy összeomlott a jegyeladás) hasonlóan, ami komoly hatással volt a fogyasztóbarát internetes jegyeladás átalakítására, az énekesnőről készült fake pornó körül kialakuló botrány is nemzetközi szintű szabályozásokat kényszerít ki a törvényhozókból.